为什么我们需要了解搜索引擎工作原理呢?因为只有我们对搜索引擎工作原理熟悉了我们的网站才会有好的收录,那么我们的网站更新文章搜索引擎它是怎么知道?

这个就需要搜索蜘蛛来爬取了,它是负责搜集、更新环节,它像蜘蛛一样在网络间爬来爬去,因此通常会被叫做“spider”为了不让更多网站的页面给迷恋住,各大搜索引擎的蜘蛛都只能通过网站的源代码来评价一个网站。

代码越精简文字内容这样的形式蜘蛛是非常喜欢的。图片加上ait属性也很受蜘蛛口味的!

蜘蛛最不喜欢的就是flashjs网站尽量少用、以下内容是小牛seo的个人观点。

工作原理一、网页抓取

蜘蛛会通过超链接的方式进行页面抓取,可以从这个页面爬取到另外一个页面,只要超链接的存在它就能顺利的爬取。

抓取偏好一般是从上往下,从左往右的这种形式。我们重要的内容就一定要在网站最上方进行显示,方便蜘蛛在第一时间发现。

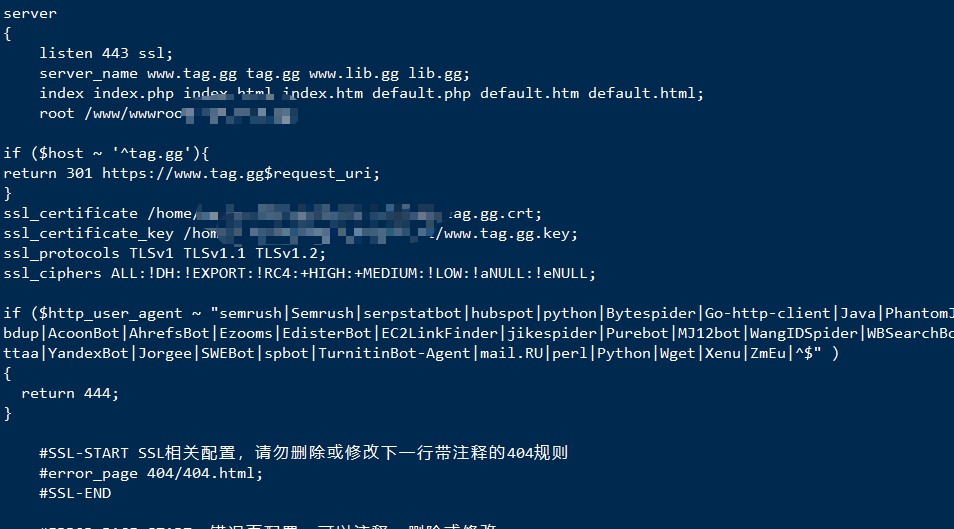

我们怎么知道搜索引擎的蜘蛛有没有来我们的网站抓取内容呢?

这个时候我们就需要看我们空间里面的iis日志了,里面记录蜘蛛抓取的每一条记录。

通过iis日志我们可以看出很多重要的东西与问题。

工作原理二、网页的内容去重处理与质量把控

蜘蛛抓取的网页后,还需做大量的处理工作。将抓取回来的内容进行技术过滤是否数据库里已经存在大量重复内容并判断是否有价值,大量通过采集或伪原创工具生成的文章页面将会在这一环节被处理掉。

工作原理三、对有价值的页面建立索引库

结合以上二步,没有被过滤的高质量页面就会进入建立索引这环节、当然最重要的就是建立索引了,有了索引的内容页面才资格去参与排名。

工作原理四、输出结果

经过网页抓取、页面重复去除、建立索引后再通过中文分词分析超链接、结合网页的重要度及内容丰富度这些的过滤后才会展示给我们的用户。

通过以上四个步骤,就能大致了解到搜索引擎的工作原理。同时也能解决掉日常工作当中的一些小的困惑,如:内容收录了怎么没有排名?发布的文章搜索引擎怎么不收录等问题。

写在最后:seo付费问题解答已开通,欢迎将你遇到问题进行反馈,小牛seo为你提供优质解答服务、先咨询后打赏!

文章评论 本文章有0个评论