【文化站长】回顾总结2017年的网站优化经历

今天复盘一些息心操盘网站时的经验,其中也提到一些前辈的case,为18年的运营工作做一下知识储备,不多说了,直接进入正文。

复盘2017年的网站优化经历

关于品牌词和长尾词的优化

忘了在哪看了一份百度出台的文件,这个文件报告中提到,网站2%的搜索的关键词带来15%的查询,就是2%的关键词是占据了整个搜索的15%。而其中,品牌词这个搜索是比较高的,同时品牌词转化率很高,搜索品牌词的人基本上都是想要购买的。

我曾经操作过的一个环评的案例,我那个网站只做seo,但是我从后台发现很多流量都是从品牌词过来的。

所以啊,品牌词做好了,也可以带来相当可观的SEO流量。

另一方面,这份报告中还提出,65.8%的查询词只出现过一次,也就是说这65.8%的搜索词用户只搜索了一次。从这里我们可以轻松联想到,我们在做SEO的时候,可以拓展别人没有想到的长尾词竞争力不强的词,这样的是比较轻松而且做出来的SEO流量也是相当可观的。

而我也确实每周都在践行这个结论:我每周都会亲自动手挖掘一批长尾关键词,交给编辑去生成内容。

这里举个同程网的例子,一般我们SEO在选择关键词的时候,会发现很多长尾关键词都被行业内的巨头所占据,那么如果再来进行竞争的话,还是比较吃力的,虽然是长尾关键词,但是竞争同样是很大的。

所以,同程旅游的SEO就改变了策略。他们在选择关键词的时候,选择了所有的地标+酒店的关键词来进行操作,比如XX路酒店、公交站牌旁的酒店、学校、地铁、XX饭店旁边的酒店,这些都是其他人没有做的,他们将这些词做上去后,流量提升还是很多的。关于这种操作方式,还可以参考这篇文章:大型网站的SEO引爆点[完整版]

关于竞品词的优化

通过品牌词优化的介绍,我们了解了网站有一部分可观的流量是从品牌词过来的,那么我们做SEO的时候就可以进行大量品牌词的挖掘,可以利用别人的品牌词来截流导入自己的网站。

比如,麦包包网站就是把淘宝网这个关键词做上去了,别人搜索进来还是有很大的成交的。

再比如,我再下一个点中提到的那个婚纱站的例子,也是通过做酒店词来引流到自己的婚纱网站上。(本文往下拉就能看到)

关于网站词库

其实不管你做了还是没做词库,每个网站运行一段时间之后都会生成出自己的词库,唯一的区别就是,有的网站在建站之初就有了词库,而有的网站是没怎么去管,自然出现的。

作为一个SEO运营人,我们当然要在网站搭建之处就把词库也准备好,方便后面我们有计划的布局关键词以及生成对应的页面。

一般有了词库之后,我们就会根据词库中去挖掘一些竞争小的长尾关键词,这样不仅仅是操作轻松,而且同样可以获得可观的SEO流量。

由于,65.8%的词用户只搜索过一次,所以其他网站不可能把这么多的词挖掘到,所以我们还是有很大的蓝海去挖掘长尾关键词的。

对于这些词来说,很多人都是没有做的,如果我们筛选挖掘出来之后,进行操作。那么,当用户搜索的时候,只有你的站点匹配,用户也只能来的你的网站,这样就很有可能给你的网站带来效益。

关于词库的建立,自己可以从网上找,像一些关键词挖掘工具、采集什么的都可以建立好一个词库。参考文章:SEO如何管理大量的长尾关键词

需要记住的第一点就是,我们要从我们自己网站的词库中,挖掘到别人不做的关键词,找到那些竞争力不强的关键词来进行操作。

这里举一个case:

在婚纱摄影行业,婚纱行同样是竞争比较大的,一般的筛选到的关键词就是婚纱的款式、婚纱的颜色等,而我们已经了解了要挖掘别人不做的关键词,所以我们在做婚纱站的时候就去筛选的结婚需要的酒店词、拍婚纱照的方式的词,因为结婚的人都需要在酒店举行婚礼,可能还需要乐队呀什么的,然后进行采集一些内容放到自己的网站上,同样会带来流量。

关于伪原创

对于常规的伪原创的话,一般我们都是采集过来一篇文章,进行换词、调整段落等,其实这种方法效率是非常低的。

这个时候我们要站在搜索引擎的角度上来考虑,根据目前搜索引擎主流的去重策略,每个页面都有专门的编号,搜索引擎首先会对页面进行提取指纹的操作。

比如,你的文章有100个文字,那么搜索引擎会从中找到5、6个你页面中独一无二的词,进行散列。散列到4段16字节的数值中,在这4段数值中,取去掉公共的部分。比如取第一段是相同的,然后余下的三段在网页中进行对比,这样就能够去掉重复的。

所以如果你只是简单的换词、调整段落的话,根本就没有把指纹去掉,这样做的伪原创全部都是无用功,浪费时间浪费钱。

当然还有其他算法,就是提前特征的指纹,算是一种投机取巧的方式吧。一般用于报纸、论文等的去重,比如就是提取页面中的标点、助词、停词等,提取这些词在页面中的分布;还有就是,提前这些词的前后的词语是什么,作为一种指纹进行对比。

当你了解了这些,就会发现我们传统的伪原创效率是非常低的。

同时,考虑到模板的不同,就算你伪原创,也有下面几个可能:

相同内容相同模板。这样的类似于镜像站,搜索引擎对于这样的网页的话,会进行聚类,将这些页面聚成一个网页,所以不一定会排序到你。

相同内容不同模板。这样的页面就类似于转载,也不一定会排序到你。

内容略不同模板相同。这个就很有可能被搜索引擎判为作弊,如果是转载过来的话,那么内容中应该是相同的,如果你调整了内容的话,可能是作弊方面的,比如采集。

内容略不同模板不同这种类似大型门户网站的转载情况,比如新闻类的,就一件事,内容怎么改也是大同小异,这种搜索引擎就会将这个页面在搜索结果里放出来。

所以,如果是伪原创的话,内容尽管很重要,但是模板同样也是非常重要的,下面就来说下模板的优化。

关于网站模板优化

处理模板的时候,需要注意一些细节方面的问题。就拿我现在的一个网站的例子来说明,每次为网站进行整站静态页更新之后,网站的流量就会变少,这在一开始的时候我认为是服务器负载过高导致的,而事实是,服务器是很小一方面原因,真正的原因在于我的更新策略出现了严重的问题。

下面我详细解释:

我们的网站都是更新的,在不断的添加内容。每次添加之后,都会生成一个静态页面,而我们大多数的网站,都会有一个最新文章版块。当我们添加内容的时候就会显示,如果我们在同一个时间段内更新了大量的文章的话,那么每个页面上的最新文章版块的链接是不一样的。

比如,你的网站每天发一万篇文章的话,需要花费一定的时间,在你发布了一篇文章之后,发布的这篇文章页面上的最新文章版块链接生成,这样以此类推。

这一万篇文章页面上的最新文章版块链接都是不同的,这样就建立了一个灵活的内部链接!

但是,如果当你要改动网站模板或者搬移网站的时候,肯定要在改完之后重新生成全站页面,那么这个时候,你的每个页面的最新版块那里,将会全部调用此时最新的文章!

那么以前那个强大灵活的内部链接结构就会被彻底打乱了!这一万篇文章页面的内链都会指向当前的最新文章。

这样本来很好很强大的内部链接消失了,进而可能会导致排名消失,进而影响SEO流量。

所以,在这种情况下,尽管你什么都没有做,但是排名和流量都下下降甚至消失了,这就是一个模板处理的细节。

所以真正的策略是:上线新模板之后,不要全部更新页面,而是要每天定量去更新。

下面我再说一个模板里的模块——随机调用模块。

如果你的网站是中大型的,就不要使用随机调用的内链规则。我知道你的设想是好的,如果每个页面有一个随机调用的模块在,就会使每个页面的展示都不一样,降低样板文字,增强排序能力,但是你忽略了一个重要的问题…..

如果你网站的内容是比较多的话,那么在随机调用文章的话,会影响到服务器速度,这个同样会影响SEO流量的,而且在调用内容的时候,最好还是相关内容的调用。

所以,能不用随机调取就不要用随机调取,吃力不讨好。

关于用户体验

我们在做SEO的时候需要时刻注意的是我们要站在搜索引擎角度来进行考虑问题,别站在自己的角度想事情,站在自己的角度肯定是网站要盈利,但是你想不想盈利关搜索引擎什么事?你有你的生意,搜索引擎有搜索引擎的生意,只有你把搜索引擎的生意帮到位了,搜索引擎才会反过来帮你,你只有站在搜索引擎的角度考虑问题,搜索引擎才会把流量给你让你去盈利。

如果你的网站是站在搜索引擎的角度考虑,让网站的内容服务好它带给你的用户,那么搜索引擎就会持续给你流量。

在商业的世界里,合作才能双赢的规则你应该懂,这个规则在做网站的时候也不例外,你一心想着让自己在搜索引擎里盈利,但不管不顾搜索引擎带给你的用户,你觉得对方还会继续跟你合作吗?

目前对于搜索引擎来说,用户体验是越来越重要了,所以在熊猫算法出来之后,有一批电商站进行了调整。

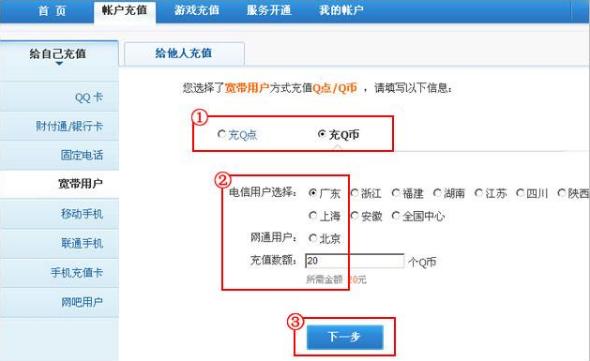

现在几乎每个网站电商站都有一个分面导航(我叫它筛选器,也有人叫过滤器),这是什么意思呢?就是当用户搜索产品的时候,他想要找到的是一个产品,从而进行购买行为,但是当你把几百个产品作为一个列表展现给他的时候,这基本上是没有什么用的,用户不可能都看一遍,他需要进行筛选。

比如,搜索一个包包,那么搜索结构的产品中可能会出现几万个包包,他需要在筛选项上点击下一个条件,比如喜欢棕色的,进入之后,发现包包有点贵,就会选择了一个便宜点的价位,这样是非常有利于用户的,这个就是用户体验。

关于外链

其实,发外链大家都懂的,只是发多发少的问题,需要注意两点就是,一个是外链的速度,另一个是相关性。

而就目前来说,搜索引擎依靠外链来排名的方式已经降低了不少,并且未来也会越来越低。以前,搜索引擎初期依靠链接来判断排名。而对于搜索发展至今的话,也越来越转向用户体验了,就想其官方说的,链接是否传递权重要看用户或者网站是否是真心推荐。

而且目前来说社交化的发展也是一种趋势,比如百度分享,这些对排名都是有影响的,未来这些可能会作为排名的一个要点。

关于SEO数据化

我们大部分的SEO做数据分析为了分析而分析,这样的话根本不知道分析出来后该做什么。我们要把数据分析的很细,这样的话从中找出问题的话,进行解决。

尤其是爬虫的数据,像抓取饱和度、抓取深度、常见入口页面、每天到访次数、停留时间等,这些数据维度,是开发搜索引擎爬虫的工程师每天都在关注的维度,我们作为SEO又有什么理由不去关注呢?

下面就针对爬虫数据做一些经验之谈:

首先你不得不明确一个观念:每一个网站所获取的搜索引擎爬虫在单位时间内的抓取量是一定的,这个量的多少是由网站本身权重来决定的。网站权重高,抓取量就大,网站权重低抓取量就比较少。

原因是:搜索引擎也有成本,每一只蜘蛛都是成本,不可能不要钱的把蜘蛛的派出去。

所以如果在一个权重比较低的网站里,它的页面比较多,搜索引擎爬虫也不敢确定你网页的质量,如果它拼命的爬取的话,万一出现抓取错误了怎么办,不是白白浪费资源吗。

所以我们做数据分析的时候,就一定要站在大前提下进行分析,爬虫量在一定时间内是恒定的,我们要分析的就是如何通过数据把这些爬虫量的爬取效率最大化。

什么效率最大化,我这有解释,爬虫量是一定的,如果80%的量来到你网站抓取的都是没有用的页面(比如关于我们,联系我们这些页面),那么就只剩下20%的资源去抓取有用的页面了,这样的效率你想要吗?所以我们需要去分析日志,分析爬虫抓取的爬取情况来进行调整,通过robots.txt和nofolow来引导爬虫去爬你认为有用的页面。这一点可以去参考:五大基本维度分析网站日志

比如,有一个朋友做了一个网站,流量排名都比较不错,于是就拿着这个网站的模板重新做了个网站,但是却发现网站收录都不怎么收录了,那么这是模板的问题吗?肯定不能随便下判断,首先去查看日志:发现搜索引擎爬虫只抓取图片和CSS文件,而html页面根本都不爬取。然后用百度站在工具的爬取诊断那里做测试,发现返回的是500,这样问题就找出来了,找到是服务器空间配置的问题,阻止了爬虫网站,在调试了空间之后,问题就解决了,这个就是查询日志的威力。

再举个例子,之前遇到一个case是一个网站的天气频道,这个频道每天只有几百流量,并不是很好于是就查询了日志。发现这个频道每天蜘蛛抓取5000个页面,但是发现有3000个页面是404。

于是便开始查看了网站这些URl,发现这些链接也确实是404页面。原因是标准化的meta标签写错了,导致这么多404。改变之后,抓取正常流量也就上升至几千了。如果这个案例就这样结束的话,也没有什么意思。

后面继续分析天气频道,现在发现3000个404变为1000个404。然后,就把这些url导出来,但是发现这些页面能够打开,而搜索引擎爬虫爬的时候就是404。

虽然很是没有头绪,但是归根到底还是需要分析日志。后来就拿所有的日志信息继续来分析,发现这些404的url报错是很有规律的,都是在半夜1、2点时间内报错,但是服务器并没有关机啊什么的。而后就开始研究代码,很有可能是半夜程序、服务器啊什么报错。

大家都知道,预报天气的话不是预报出很长时间的,就是预报一周的,所以每天需要生成今天之后的七天的天气页面的url,因为预报天气的这些数据都不是我们网站自己的,我们都是根据中国天气气象官网上采集下来的。我们每天发布天气信息的时间比生成预报天气的这个链接要晚。也就是说,半夜我们可以查询七天后的天气,但是我们还没有更新,所以导致爬虫出现404。

这样我们修改后,就慢慢的不出现这种情况了。对于这种问题,如果只靠你的SEO经验、程序的话,是很难发现的,只有通过数据分析的力量解决才行。

SEO以数据来指导,调整相应的策略。

SEO领域是一个很大很广的范畴,一个网站不是你发几篇文章发几条外链就可以做上排名的,需要不断的来学习,实操才能有所成绩。另外一点经验也是息心深刻体会到的,那就是不要以为SEO过时了,其实你操作SEO的时候就是你不断跨界的机会。每个网站所在的行业都有其独特的思考视角,通过操盘一个个网站,你就会发现很多不一样的商机,并且在操盘网站的过程中会累积很多技能,这些技能都会在你今后的日子里绽放出弥足珍贵的价值。

文章评论 本文章有个评论